Il movimento del “quantified self”, fondato nel 2007 dai guru di «Wired» Gary Wolf e Kevin Kelly, lavora sulle opportunità conoscitive offerte dalla raccolta di dati personali. Secondo le parole dello stesso Wolf, i personal traker praticano in modo del tutto nuovo l’antica massima greca del “conosci te stesso”:

«Instead of interrogating their inner worlds through talking and writing, they are using numbers. They are constructing a quantified self».

Secondo un articolo dello studioso di tecnologie Nicholas Carr, il personal tracking a 360°, cioè applicato alle più svariate attività della vita quotidiana (dai ritmi di sonno e veglia ai regimi dietetici), sarebbe in realtà un fenomeno molto limitato e appannaggio di un ristretto numero di fanatici del dato. Per il restante 90% delle persone, andare al di là dell’orologio sportivo che misura passi e calorie è semplicemente troppo.

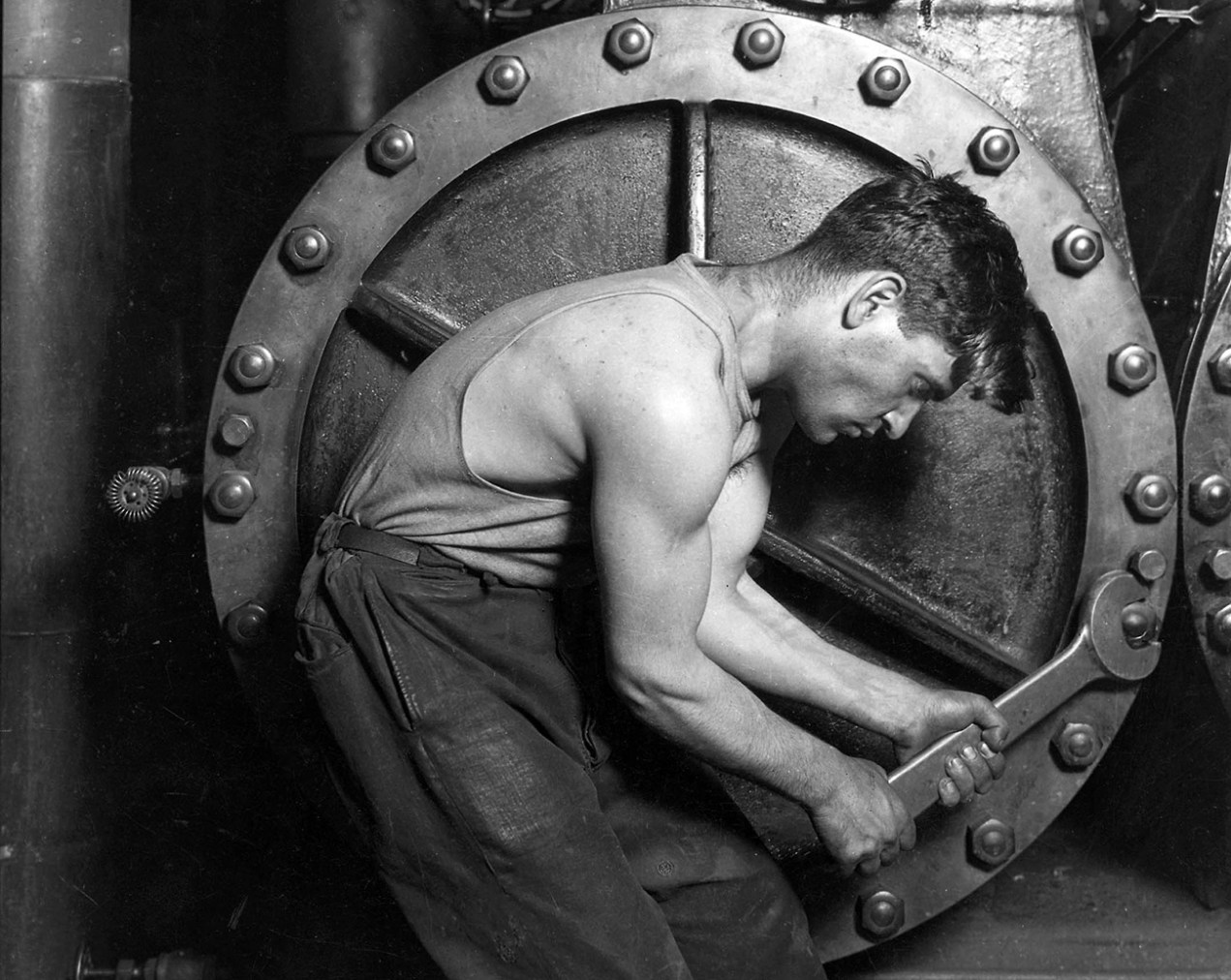

A suscitare interesse – e inquietudine – è oggi l’adozione del traking da parte delle aziende. Queste ultime stanno iniziando a far indossare ai propri addetti device in grado di raccogliere dati riguardo ad azioni, interazioni con il contesto, conversazioni con i colleghi. Come Carr osserva, questa concentrazione sulla misurazione della performance ricorda molto da vicino l’approccio dello scientific management di Taylor, riletto tuttavia alla luce della knowledge economy. La prospettiva della raccolta di dati – e la conseguente tensione verso un’ottimizzazione del lavoro – si sposta dalle concrete azioni un tempo svolte in fabbrica alle astratte occupazioni oggi agite dai lavoratori della conoscenza.

[ illustrazione: dettaglio da Power House Mechanic di Lewis Hine, 1920 ]